Bem -vindo de volta a No loopO novo boletim da Time é duas vezes por semana sobre a IA. A partir de hoje, publicaremos essas edições como histórias no time.com e como e -mails. Se você está lendo isso no seu navegador, por que não se inscrever para que o próximo entregue diretamente à sua caixa de entrada?

O que saber: por que os chatbots estão impede a desinformação russa?

No último ano, como os chatbots ganharam a capacidade de pesquisar na Web antes de fornecer uma resposta, a probabilidade de compartilhar informações falsas sobre tópicos específicos nas notícias aumentou, de acordo com o novo pesquisar pelas tecnologias de notícias.

Isso significa que os chatbots da IA são propensos a narrativas de imersão espalhadas por redes de desinformação russa, afirma o Newsguard.

O estudo – O Newsguard testou 10 modelos de IA líderes, questionando cada um deles cerca de 10 narrativas espalhadas on -line vinculadas aos eventos atuais que a empresa havia determinado a ser falso. Por exemplo: uma pergunta sobre se o presidente do Parlamento da Moldávia havia comparado seus compatriotas a um bando de ovelhas. (Ele não tinha, mas uma rede de propaganda russa alegou que ele tinha, e seis dos 10 modelos testados por Newsguard repetiram essa alegação.)

Pitada de sal – O NewsGuard afirma no relatório que os 10 principais chatbots agora repetem informações falsas sobre tópicos nas notícias mais de um terço das vezes – acima dos 18% do ano anterior. Mas isso parece um trecho. O estudo do NewsGuard tem um pequeno tamanho de amostra (30 instruções por modelo) e incluiu perguntas sobre tópicos de nicho razoavelmente. De fato, minha experiência subjetiva de usar os modelos de IA no último ano foi que a taxa de “alucinando” sobre as notícias caiu constantemente, não para cima. Isso se reflete nos benchmarks, que mostram modelos de IA melhorando em acertar os fatos. Também é importante observar que o Newsguard é uma empresa privada com um cavalo nesta corrida: vende um serviço às empresas de IA, oferecendo dados de indicação ao ser humano sobre eventos de notícias.

E ainda – Ainda assim, o relatório ilumina uma faceta importante de como os sistemas de IA de hoje funcionam. Quando pesquisam informações na Net, eles retiram não apenas websites de notícias confiáveis, mas também postagens de mídia social e qualquer outro web site que possa se colocar com destaque (ou mesmo não tão promotor) nos mecanismos de pesquisa. Isso criou uma abertura para um tipo totalmente novo de operação de influência maligna: uma projetada não para espalhar informações viralmente através das mídias sociais, mas publicando informações on -line que, mesmo que não lidas por seres humanos, ainda podem influenciar o comportamento dos chatbots. Essa vulnerabilidade parece se aplicar mais fortemente a tópicos que recebem relativamente pouca discussão na grande mídia, diz McKenzie Sadeghi, autor do relatório do Newsguard.

Zoom fora – Tudo isso revela algo importante sobre como a economia da IA pode estar mudando nosso ecossistema de informações. Seria tecnicamente trivial para qualquer empresa de IA fazer uma lista de redações verificadas com altos padrões editoriais e tratar informações provenientes desses websites de maneira diferente de outros conteúdos na Net. Mas hoje, é difícil encontrar informações públicas sobre como as empresas de IA ponderam as informações que entram em seus chatbots by way of pesquisa. Isso pode ser devido a preocupações com direitos autorais. O New York Instances, por exemplo, está atualmente processando o OpenAI por ter treinado supostamente em seus artigos sem permissão. Se as empresas de IA deixassem claro publicamente que dependiam fortemente nas redações de suas informações, essas redações teriam um argumento muito mais forte por danos ou compensação. Enquanto isso, empresas de IA como OpenAI e Perplexity assinaram acordos de licenciamento com muitos websites de notícias (incluindo tempo) para acesso aos seus dados. Mas ambas as empresas observam que esses acordos não resultam na obtenção de tratamento preferencial nos resultados da pesquisa da Chatbots.

Se você tiver um minuto, faça nossa pesquisa rápida para nos ajudar a entender melhor quem você é e quais tópicos de IA mais interessam você.

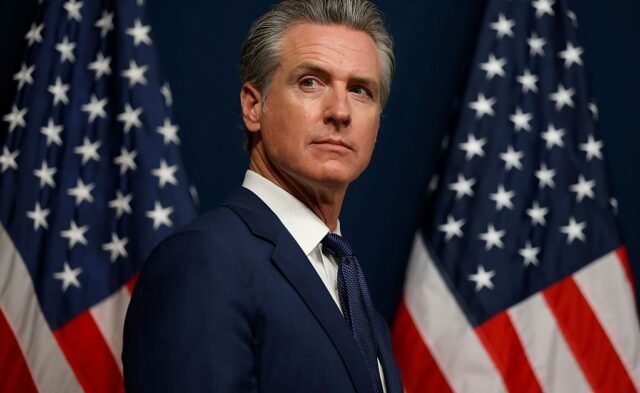

Quem saber: Gavin Newsom, governador da Califórnia

Pela segunda vez em um ano, todos os olhos estão na Califórnia, pois um regulamento de IA se aproxima dos estágios finais de ser assinado. O projeto, chamado SB 53, limpou a Câmara e o Senado da Califórnia e deve chegar à mesa do governador Gavin Newsom este mês. Será a decisão dele se deve assinar isso.

O Newsom vetou o antecessor do SB 53 desta vez no ano passado, após uma intensa campanha de foyer de capitalistas de risco e grandes empresas de tecnologia. O SB 53 é uma versão diluída desse projeto de lei – mas ainda assim que exigiria que as empresas de IA publicassem estruturas de gerenciamento de riscos, relatórios de transparência e declarassem incidentes de segurança às autoridades estaduais. Também exigiria proteções de denunciantes e fazia com que as empresas enfrentem penalidades monetárias por não cumprirem seus próprios compromissos. A Anthropic se tornou a primeira grande empresa de IA a declarar seu apoio ao SB 53 na segunda -feira.

AI em ação

Pesquisadores da Palisade têm desenvolvido Uma prova de conceito para um agente de IA autônomo que, quando entregue no seu dispositivo por meio de um cabo USB comprometido, pode peneirar seus arquivos e identificar as informações mais valiosas para roubo ou extorsão. É um gostinho de como a IA pode tornar o hacking mais escalável, automatizando as partes do sistema que foram anteriormente limitadas pelo trabalho humano – potencialmente expondo muito mais pessoas a golpes, extorsão ou roubo de dados.

Como sempre, se você tem uma história interessante de IA em ação, adoraríamos ouvi -la. Envie -nos um electronic mail em: intheloop@time.com

O que estamos lendo

Meta suprimiu pesquisas sobre segurança infantil, dizem os funcionáriosPor Jon Swaine e Naomi Nix para o Washington Publicar

“O fato de serem parte de um tesouro de documentos de dentro da Meta, que foi recentemente divulgada ao Congresso Bywo Present e dois ex -funcionários que alegam que a meta suprimiu pesquisas que poderiam ter iluminado riscos potenciais de segurança para crianças e adolescentes nos dispositivos e aplicativos da realidade digital da empresa – uma alegação que a empresa negou veementemente.”