Siga ZDNet: Adicione -nos como uma fonte preferida no Google.

As principais toca de Zdnet

- O mais recente estrutura de segurança do Google Frontier explora

- Ele identifica três categorias de risco para a IA.

- Apesar dos riscos, a regulamentação permanece lenta.

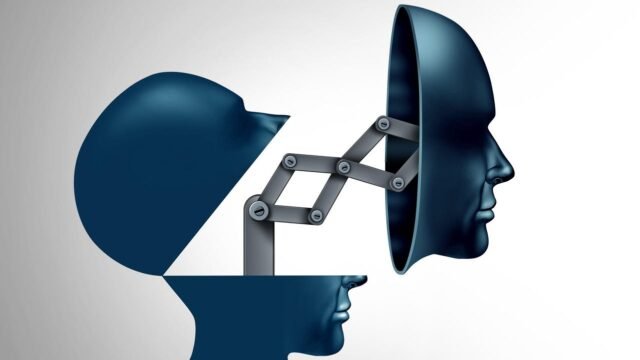

Uma das grandes ironias do boom da IA em andamento foi que, à medida que a tecnologia se torna mais tecnicamente avançada, ela também se torna mais imprevisível. A “Black Box” da AI fica mais escura à medida que o número de parâmetros de um sistema – e o tamanho do seu conjunto de dados – cresce. Na ausência de uma forte supervisão federal, as empresas de tecnologia que estão tão agressivamente empurrando as ferramentas de IA voltadas para o consumidor também são as entidades que, por padrão, estão estabelecendo os padrões para a implantação segura da tecnologia em rápida evolução.

Além disso: os modelos de IA sabem quando estão sendo testados – e mudam seu comportamento, mostra a pesquisa

Na segunda -feira, o Google publicou A última iteração de sua estrutura de segurança de fronteira (FSF)que procura entender e mitigar os perigos colocados pelos modelos de IA líder do setor. Ele se concentra no que o Google descreve como “níveis críticos de capacidade” ou CCLs, que podem ser pensados como limiares de capacidade além dos quais os sistemas de IA poderiam escapar do controle humano e, portanto, colocam em risco usuários ou sociedade em geral.

O Google publicou sua nova estrutura com a intenção de definir um novo padrão de segurança para desenvolvedores de tecnologia e reguladores, observando que eles não podem fazer isso sozinho.

“Nossa adoção deles resultaria em mitigação de riscos eficazes para a sociedade somente se todas as organizações relevantes fornecessem níveis semelhantes de proteção”, escreveram a equipe de pesquisadores da empresa.

Além disso: a IA não é ‘raciocínio’ – como essa equipe desmascarou o hype da indústria

A estrutura se baseia em pesquisas em andamento em toda a indústria de IA para entender a capacidade dos modelos de enganar e às vezes até ameaçar usuários humanos quando percebem que seus objetivos estão sendo prejudicados. Essa capacidade (e seu perigo acompanhante) cresceu com a ascensão de agentes de IA, ou sistemas que podem executar tarefas de várias etapas e interagir com uma infinidade de ferramentas digitais com o mínimo de supervisão humana.

Três categorias de risco

A nova estrutura do Google identifica três categorias de CCLs.

O primeiro é o “uso indevido”, no qual os modelos fornecem assistência com a execução de ataques cibernéticos, a fabricação de armas (química, biológica, radiológica ou nuclear) ou a manipulação maliciosa e intencional de usuários humanos.

O segundo é “P&D de aprendizado de máquina”, que se refere a avanços técnicos no campo que aumentam a probabilidade de que novos riscos surjam no futuro. Por exemplo, imagine uma empresa de tecnologia que implanta um agente de IA cuja exclusiva responsabilidade é criar meios cada vez mais eficientes de treinar novos sistemas de IA, com o resultado, sendo que o funcionamento interno dos novos sistemas que estão sendo produzidos são cada vez mais difíceis para os humanos entenderem.

Além disso: a IA pensa como seres humanos? Não estamos nem perto – e estamos fazendo a pergunta errada

Depois, há o que a empresa descreve como CCLs “desalinhamento”. Eles são definidos como casos em que os modelos com recursos avançados de raciocínio manipulam usuários humanos por meio de mentiras ou outros tipos de engano. Os pesquisadores do Google reconhecem que essa é uma área mais “exploratória” em comparação com os outros dois, e seus meios sugeridos de mitigação – um “sistema de monitoramento para detectar o uso ilícito de recursos de raciocínio instrumental” – é, portanto, um pouco nebuloso.

“Uma vez que um modelo é capaz de raciocínio instrumental eficaz de maneiras que não podem ser monitoradas, mitigações adicionais podem ser justificadas – cujo desenvolvimento é uma área de pesquisa ativa”, disseram os pesquisadores.

Ao mesmo tempo, no fundo da nova estrutura de segurança do Google é um número crescente de contas de Psicose da IAou instâncias em que o uso prolongado de AI Chatbots faz com que os usuários entrem em padrões de pensamento ilusórios ou conspiratórios, pois suas visões de mundo preexistentes são recursivamente refletidas de volta para eles pelos modelos.

Além disso: se seu filho usa chatgpt em angústia, o OpenAI notificará você agora

Quanto da reação de um usuário pode ser atribuída ao próprio chatbot, no entanto, ainda é uma questão de debate legal e, fundamentalmente, não está claro neste momento.

Uma paisagem de segurança complexa

Por enquanto, muitos pesquisadores de segurança concordam que os modelos de fronteira que estão disponíveis e em uso dificilmente realizarem os piores desses riscos hoje – muitos testes de segurança abordam problemas de problemas futuros podem exibir e pretende trabalhar para trás para evitá -los. Ainda assim, em meio a controvérsias de montagem, os desenvolvedores de tecnologia foram trancados em uma corrida crescente para construir mais chatbots de AI e agênticos.

Além disso: vibrações ruins: como um agente de IA codificou seu caminho para desastre

Em vez de regulamentação federal, essas mesmas empresas são os principais órgãos que estudam os riscos representados por sua tecnologia e determinando salvaguardas. O Openai, por exemplo, apresentou recentemente medidas para notificar os pais quando crianças ou adolescentes estão exibindo sinais de angústia enquanto usam o ChatGPT.

No equilíbrio entre velocidade e segurança, no entanto, a lógica bruta do capitalismo tendeu a priorizar o primeiro.

Algumas empresas têm empurrado agressivamente os companheiros de IA, avatares virtuais alimentados por grandes modelos de idiomas e destinados a se envolver em conversas humanas – e às vezes abertamente paquera – com usuários humanos.

Além disso: mesmo o CEO da Openai, Sam Altman, acha que você não deve confiar na IA para terapia

Embora o segundo governo Trump tenha adotado uma abordagem geralmente frouxa da indústria de IA, dando-lhe uma ampla margem de manobra para construir e implantar novas ferramentas voltadas para o consumidor, a Comissão Federal de Comércio (FTC) lançou uma investigação no início deste mês em sete desenvolvedores de IA (incluindo alfabetos, empresa-mãe do Google) para entender como o uso de companheiros de IA poderia ser prejudicado.

A legislação local está tentando criar proteções enquanto isso. Lei de Estado da Califórnia 243Enquanto isso, o que regulamentaria o uso de companheiros de IA para crianças e alguns outros usuários vulneráveis, passou tanto a Assembléia Estadual quanto o Senado e precisa ser assinado apenas pelo governador Gavin Newsom antes de se tornar a lei estadual.